как происходит индексация сайта

Как проиндексировать сайт в Яндексе, Google и других поисковиках

Индексирование сайта — что это и для чего необходимо?

Индексация сайта в поисковых системах — необходимое условие его видимости при поиске в интернете. Если просто создать сайт и не заботиться о его индексации, скорее всего, на него смогут попасть только те, кто знает непосредственный адрес домена.

Индексирование — это процесс считывания страниц сайта роботом той или иной поисковой системы с последующим добавлением данных страниц в базу поисковой системы

Краулеры с некоторой периодичностью обходят страницы сайта, считывая

И множество других данных.

Благодаря тому, что поисковая система узнаёт о сайте, она способна предлагать и продвигать его в результатах поиска. На основе контента, ссылок и ряда факторов определяется тематическая категория сайта, ключевые фразы, по которым он наиболее релевантен поисковым запросам.

Таким образом, поисковая система предлагает пользователям страницы вашего сайта, максимально соответствующие их запросам.

Индексация всего лишь способствует актуализации материалов сайта. Благодаря этому страницы и их содержимое, во-первых, попадают в поисковую выдачу с наименьшей задержкой. А, во-вторых, постоянно обновляются.

Как эффективно проиндексировать сайт

Чтобы сайт как можно быстрее начали индексировать поисковые системы, его надо добавить в базу поисковиков через инструменты для вебмастеров.

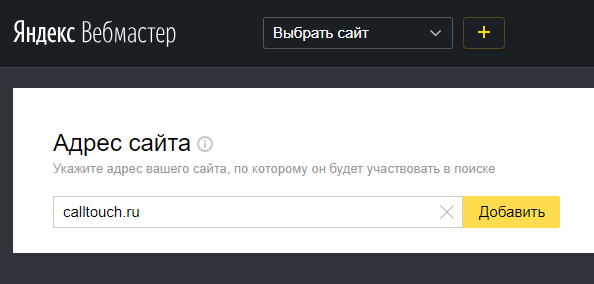

Добавьте сайт в Яндекс.Вебмастер

Простой ответ на вопрос «Как проиндексировать сайт в Яндексе?» — добавить его в Вебмастер.

В том же меню есть информация о том, когда и с каким результатом робот обходил страницы, какие из них есть в поиске, а также функция добавления Sitemap, запуска переобхода и настройки скорости обхода.

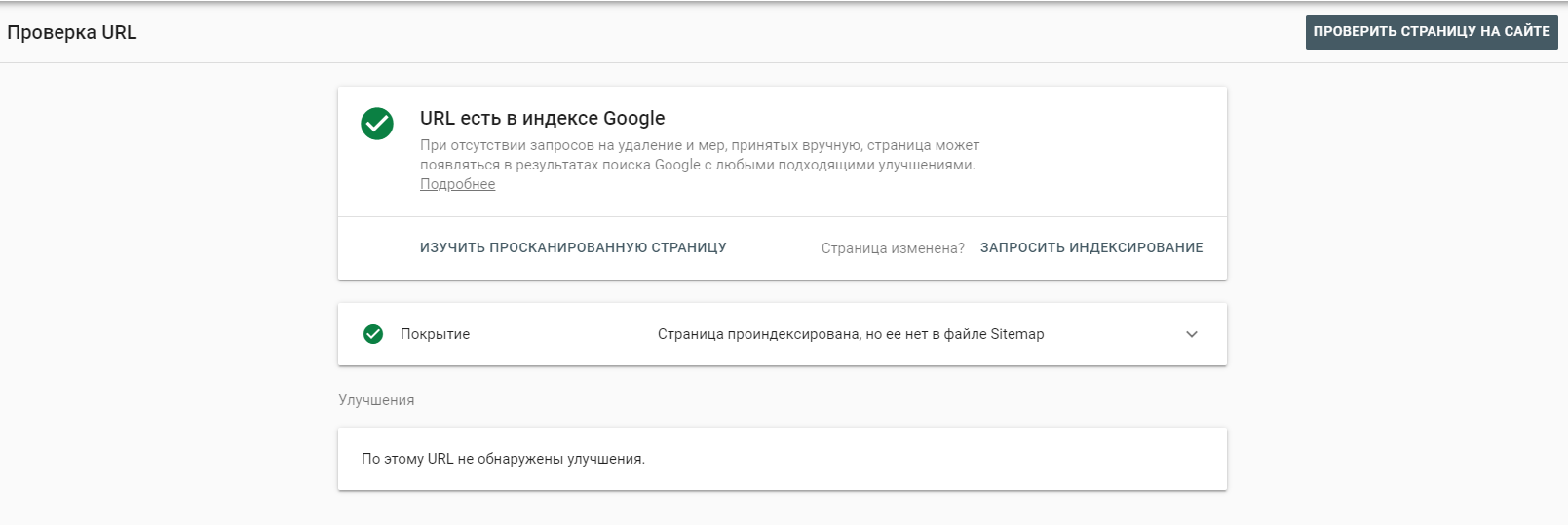

Добавьте сайт в Google Search Console

Перейдите на https://search.google.com/search-console/welcome и войдите в учётную запись. Добавьте сайт в систему.

Как и в Яндекс.Вебмастере, инструмент предлагает множество отчётов о состоянии индексации сайта. Вы может увидеть, какие страницы проиндексированы и добавлены в поиск, внутренние и внешние ссылки и многое другое.

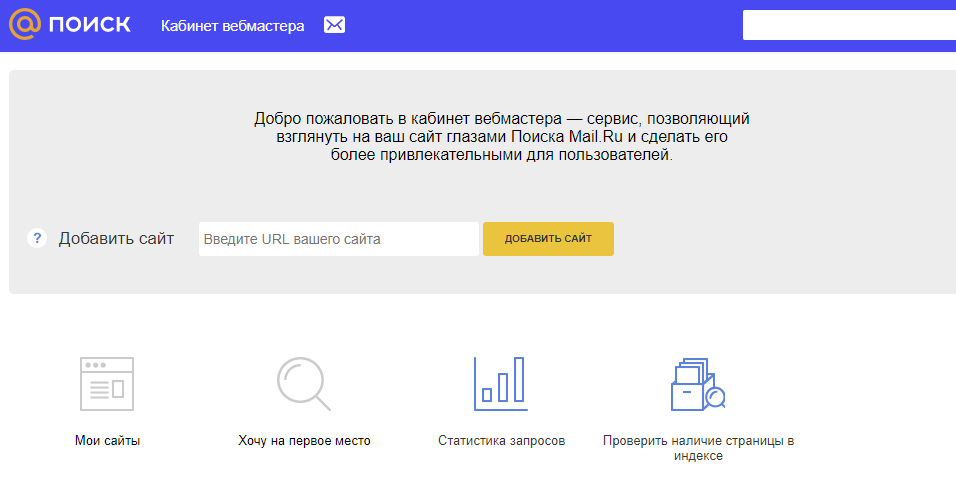

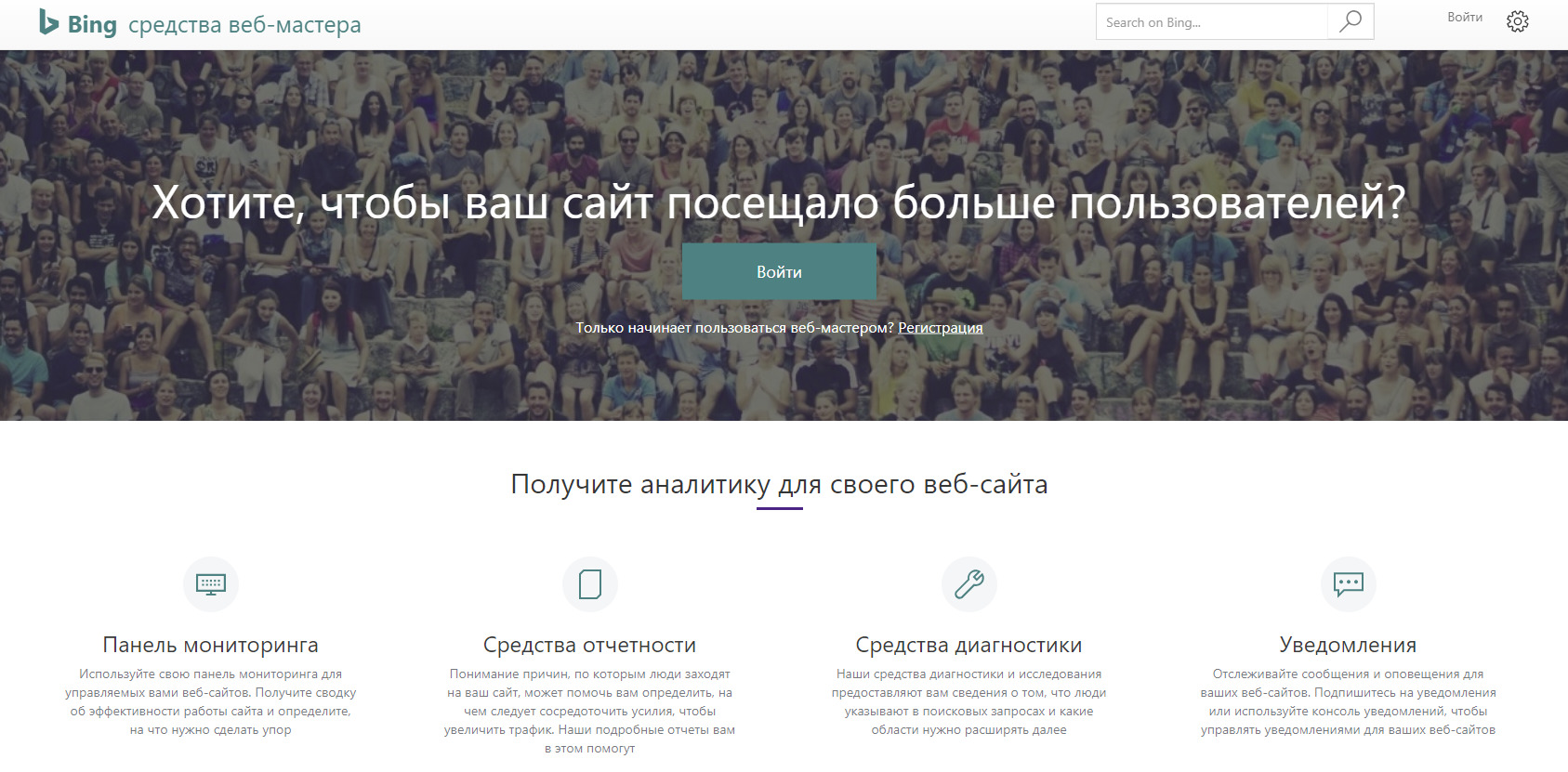

Добавление сайта в прочие поисковые системы

В российском сегменте интернета доля поисковых систем помимо Яндекса и Google стремится к нулю. Тем не менее, не следует ими пренебрегать, если сайт является важным имиджевым элементом крупного проекта или организации.

Рамблер основан на тех же данных индексации, которые собирает Яндекс — в этом случае нет необходимости в дополнительных настройках.

Как ускорить индексацию сайта в поисковиках

Создайте файл robots.txt

Файл robots.txt даёт поисковым роботам указание — какие страницы и разделы сайта следует читать, а какие — нет.

На сайте всегда присутствуют технические страницы — в частности, результаты поиска, этапы регистрации, системные файлы, теги и подобное. Также со временем может скопиться некоторый объём неактуальных страниц — контент на них может быть устаревшим или наоборот, он ждёт публикации не ранее назначенной даты.

Что такое индексация сайта

11 декабря 2017 Опубликовано в разделах: Азбука терминов. 31471

Индексация сайта значит, что робот поисковой системы посещает ресурс и его страницы, изучает контент и заносит его в базу данных.Впоследствии эта информация выдается по ключевым запросам. То есть, пользователи сети вводят в строку поиска запрос и получают на него ответ в виде списка проиндексированных страниц.

Если говорить простым языком, получится приблизительно так: весь интернет — это огромная библиотека. В любой уважающей себя библиотеке есть каталог, который облегчает поиск нужной информации. В середине 90-х годов прошлого века, вся индексация сводилась к такой каталогизации. Роботы находили на сайтах ключевые слова и формировали из них базу данных.

Сегодня боты собирают и анализируют информацию по нескольким параметрам (ошибки, уникальность, полезность, доступность и проч.) прежде, чем внести ее в индекс поисковой системы.

Алгоритмы работы поисковых роботов постоянно обновляются и становятся все сложнее. Базы данных содержат огромное количество информации, несмотря на это поиск нужных сведений не занимает много времени. Это и есть пример качественной индексации.

Если сайт не прошел индексацию, то информация до пользователей может и не дойти.

Как индексирует сайты Гугл и Яндекс

Яндекс и Гугл, пожалуй, самые популярные поисковики в России. Чтобы поисковые системы проиндексировали сайт, о нем нужно сообщить. Сделать это можно двумя способами:

Второй способ медленнее, сайт встает в очередь и индексируется в течение двух недель или больше.

В среднем, новые сайты и страницы проходят индексацию за 1–2 недели.

Считается, что Гугл индексирует сайты быстрее. Это происходит потому, что поисковая система Google индексирует все страницы — и полезные, и неполезные. Однако в ранжирование попадает только качественный контент.

Яндекс работает медленнее, но индексирует полезные материалы и сразу исключает из поиска все мусорные страницы.

Индексирование сайта происходит так:

Есть 3 способа проверки индексации сайта и его страниц в Гугл и Яндексе:

Проверяем индексацию

Это можно сделать используя:

Как ускорить индексацию сайта

От того, насколько быстро роботы проведут индексирование, зависит скорость появления нового материала в поисковой выдаче, тем быстрее на сайт придет целевая аудитория.

Для ускорения индексации поисковыми системами нужно соблюсти несколько рекомендаций.

Как закрыть сайт от индексации

Закрыть сайт от индексации — запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Обычно это делается для того, чтобы скрыть от публичного доступа секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и т. п.

Сделать это можно несколькими способами:

User-agent: *

Disallow: /

Запись для запрета индексации всего документа будет выглядеть так:

Можно создать запрет для конкретного робота:

На что влияет индексация при продвижении

Благодаря индексации сайты попадают в поисковую систему. Чем чаще обновляется контент, тем быстрее это происходит, так как боты чаще приходят на сайт. Это приводит к более высокой позиции при выдаче на запрос.

Индексация сайта в поисковых системах дает приток посетителей и способствует развитию проекта.

Кроме контента, роботы оценивают посещаемость и поведение посетителей. На основании этих факторов они делают выводы о полезности ресурса, чаще посещают сайт, что поднимает на более высокую позицию в поисковой выдаче. Следовательно, трафик снова увеличивается.

Индексация — это важный процесс для продвижения проектов. Чтобы индексирование прошло успешно, поисковые роботы должны убедиться в полезности информации.

Алгоритмы, по которым работают поисковые машины, постоянно меняются и усложняются. Цель индексации — внесение информации в базу данных поисковых систем.

Что такое индексация сайта и как её проверить

Чем бы вы ни занимались, интернет-магазином, корпоративным порталом или лендингом, сделать сайт — лишь полдела. Дальше начинается самое интересное — продвижение. Индексация в этом деле — первый шаг на пути к топу поисковой выдачи. Рассказываем о том, как она происходит, как её проверить и ускорить.

Продвижение начинается с попадания страниц сайта в индекс поисковых систем (ПС). В эти базы данных Яндекс, Google и другие сервисы заносят информацию о содержимом страниц: использованных на них ключевых словах, размещённом на них контенте и другую информацию. Затем, когда пользователь обращается к ПС с запросом, сервис анализирует собранные данные и подбирает наиболее подходящие варианты ответа из списка проиндексированных страниц.

Чтобы ваш сайт проиндексировали, о нём нужно сообщить поисковикам. Это можно сделать несколькими способами.

1. С помощью инструментов поисковых систем. Почти у всех поисковиков есть собственные сервисы для веб-мастеров. У самых популярных из них на территории СНГ — Google и Яндекс — это Search Console и Яндекс.Вебмастер. В последнем даже есть специальный инструмент, позволяющий отправлять от 20 ссылок в день на страницы, которые нужно проиндексировать в приоритетном порядке.

Однако когда речь заходит не о нескольких десятках страниц, а об индексации сайта в целом, более эффективным решением будет добавить его в Яндекс и Google, а затем указать ссылку на карту сайта (файл Sitemap) в Search Console и Яндекс.Вебмастер. Тогда поисковики начнут самостоятельно и регулярно посещать ваш сайт и его новые страницы, чтобы затем добавить их в индекс. О том, как составить карту сайта вы можете узнать в руководстве Google. Что касается скорости попадания в выдачу, она зависит от многих факторов, но в среднем занимает одну—две недели.

2. С помощью ссылок с других сайтов. Быстро обратить внимание поисковых систем на вашу новую страницу можно, разместив ссылки на неё на других порталах. Если один из них будет новостным, скорее всего, страница быстро попадёт в выдачу, так как поисковики часто проверяют такие сайты и ссылки на них считают полезными. В некоторых случаях индексирование может занять меньше суток.

Попадёт ли страница в поисковую выдачу, зависит от её содержимого. Если с ней всё в порядке, робот проиндексирует её и в скором времени она появится в поисковой выдаче.

Есть несколько способов узнать были ли проиндексированы нужные вам страницы.

1. С помощью Яндекс.Вебмастера и Search Console. В первом для этого есть специальный инструмент — «Проверить статус URL». Достаточно добавить в него ссылку на нужную страницу, и в течение двух минут (иногда — нескольких часов) вы узнаете о статусе страницы в ПС.

Чтобы проверить статус страницы в Search Console, нужно ввести ссылку на неё в поисковой строке, которая отображается в верхней части экрана. На открывшейся форме вы узнаете, была ли страница проиндексирована поисковиком.

2. С помощью команды «site». Если вы не хотите добавлять сайт в сервисы для веб-мастеров, вы можете проверить сразу все попавшие в индекс поисковиков страницы с помощью специальной команды. Для этого введите в поиск Яндекс или Google запрос вида «site:mysite.ru» (без кавычек), и вы увидите все страницы, попавшие в выдачу.

3. С помощью сервисов. Самый простой способ проверить индексацию определённых страниц — воспользоваться для этого сторонними сервисами. Например, Серпхант позволяет проверить индексацию сразу 50 страниц в Яндекс и Google. Введите ссылки на них в специальную форму (не забудьте про http:// или https://) и нажмите «Начать проверку». Иногда инструмент долго выдаёт результаты проверки по одной—двум позициям, но существенно на функциональность это не влияет.

Ещё один сервис — плагин RDS Bar для Chrome, Firefox и Opera — позволяет получить подробную информацию о любой открытой в браузере странице, в том числе и о том, проиндексирована ли она.

Чем быстрее поисковые системы внесут страницу в индекс, тем быстрее на неё попадут посетители. Чтобы сократить время ожидания, следуйте следующим рекомендациям:

Не все страницы нравятся поисковым системам. Некоторым из них — например, служебным страницам и тем, которые пока что находятся в разработке, — не только нечего делать в выдаче, но и лучше вообще не попадаться на глаза поисковым роботам. Чтобы предотвратить попадание таких страниц в выдачу, лучше сразу запретить их индексацию. Сделать это также можно несколькими способами:

1. Использовать команду Disallow в файле robots.txt. В этом файле указываются правила для поисковых роботов: какие-то страницы в нём можно разрешить индексировать определённым ПС, а какие-то — запретить. Чтобы страница не попала в выдачу, используйте команду Disallow. Подробнее о работе с файлом robots.txt читайте в руководстве Яндекса.

Индексация сайта: принципы работы, советы, секреты

Сегодня рассмотрим подробно самый важный процесс, без которого остальные процессы SEO-продвижения не работают. Мы поговорим об индексации, принципах её работы, важности, отличиях в Google и Яндекс. Также расскажем, как проиндексировать сайт любого размера и улучшить его качество.

Индексация сайта и почему она так важна

Как работает поисковая система?

Чтобы понять, что такое индексация, нужно сначала разобраться, как работают поисковые системы и почему их можно считать библиотеками Интернета.

Поисковая система — это множество серверов, на которых хранятся структурированные данные о миллионах, а возможно и миллиардах документов в Интернете. То есть когда мы запрашиваем какую-либо информацию в Google или Яндексе, мы ищем не по самому интернету, а по их поисковой базе.

Чтобы документ попал в эту базу, он должен быть известен поисковому роботу (краулер — от англ. crawler, бот, паук). Робот узнаёт о новых сайтах и страницах следующими способами:

Когда поисковой робот узнал о новом документе, он заносит его в расписание проверок и затем, если документ доступен для обхода, робот выкачивает преимущественно текстовую информацию (этот процесс ещё называют краулингом) и передаёт индексирующему роботу. После этого документ, сайт или страница могут участвовать в поиске.

Почему мы говорим о документе? Потому что робот умеет индексировать не только HTML-страницы, но и другие форматы (справка Яндекса и Google).

Что такое индексация?

Попробуем дать собственное определение этому понятию. Индексация сайта — это процесс получения, обработки, структуризации и хранения преимущественно текстовой информации о страницах сайта в поисковой базе. О получении этой информации мы уже рассказали. Под обработкой подразумеваем, что информация каждой страницы собрана и очищена от лишнего (картинки и графика, HTML-теги и т.д.). Но важнее всего остановиться на структуризации данных.

Вся полученная текстовая информация делится на отдельные слова, которые группируются в алфавитном порядке. Эти слова приводятся к их начальной форме. Алгоритмы каждой поисковой системы разнятся, поэтому мы не можем точно знать обо всех тонкостях процесса, но сам процесс называется машинной морфологией. К начальным формам слов робот добавляет адрес страницы и количество упоминаний на ней.

Почему так важна индексация?

Ответ прост: чем больше ваших страниц в поисковой базе (проиндексированы), тем больше возможностей для показа в поисковой выдаче. Выражаясь ещё проще, если вы в базе, вас могут найти.

Конечно, всё, что мы здесь описали, значительно упрощено для понимания, а некоторые тонкости и нюансы опущены. Например, логичен вопрос: вы говорите о возможностях, но не говорите о гарантиях показа. Дело в том, что индексация не гарантирует показ страниц вашего сайта, ведь после неё каждый раз включается процесс ранжирования документов по каждому отдельному запросу.

Ранжирование — это распределение страниц, имеющихся в поисковой базе, в порядке приоритета и релевантности для запросов пользователей. Если проще, то документы ваших конкурентов могут быть качественнее и релевантнее (более подходящими) по мнению поисковой системы, чем ваши. Поэтому даже если страницы вашего сайта будут находиться в индексе, не факт, что они будут показываться в поиске. А если и будут, то нет гарантий, что на 1–2 странице.

Тезис: чем больше страниц сайта проиндексированы, тем больше шансов получить трафик.

Что может мешать индексации?

Самая главная причина — робот не знает о наличии страницы либо сайта. Как мы обозначили выше, у краулера ограничены способы нахождения новых страниц. Учитывайте это и используйте все доступные меры:

Помешать индексации могут следующие причины:

Нюанс №1: для Яндекс robots.txt — важный документ, а для Google рекомендательный. То есть, если робот сочтёт страницу полезной для пользователей, он будет игнорировать запреты в файле. Для запрета индексации страницы в Гугле лучше использовать метатег robots или HTTP-заголовок X-Robots-Tag.

Нюанс №2: 3xx-редирект и атрибут rel=canonical не запрещают индексацию страницы напрямую, но указывают, что она вторична, в отличие от страницы редиректа или канонической.

Нюанс №3: указание канонической страницы не всегда спасает владельца сайта, так как Google может по своему усмотрению выбирать канонические страницы и игнорировать атрибут rel=canonical.

Краулинговый бюджет

Количество новых документов в Интернете постоянно растёт, а технологические мощности поисковых гигантов всё же ограничены. Поэтому робот решает, сколько страниц одного сайта будет индексировать за раз. Это и называют краулинговым бюджетом.

Он зависит от количества и качества страниц, частоты их обновления, типа самого сайта (маркетплейс, новостник, небольшой сайт), популярности и авторитетности ресурса. Важно отметить, что краулинговый бюджет — это не постоянная величина, и он может изменяться.

Напрямую управлять как индексированием, так и бюджетом сканирования вы не можете, но способствовать этим процессам точно можно. Об этом подробнее поговорим в разделе «Как управлять индексацией».

Индексация сайта в Google и Яндекс

Принципы индексации у этих поисковых систем преимущественно одинаковые: краулинг → очистка → индексация → ранжирование. Но различия можно найти, поэтому расскажем о тех, которые известны.

Индексация в Google

Самое главное отличие — Google лучше ориентируется в англоязычном сегменте, то есть лучше воспринимает текст и запрос пользователя на английском. Разница на момент 2020, думается, незначительная, но учитывать стоит.

У Гугла 2 основных типа роботов: для мобильных сайтов и для десктопных. Новые сайты индексируются мобильными роботами и приоритет отдан мобильным версиям сайта, согласно алгоритму mobile-first индекс.

Скорость индексации обычно выше, чем у Яндекса: на 1 страницу уходит неделя или меньше. Индекс обновляется постоянно, а некачественные страницы не удаляются из него, но при этом и не показываются пользователям.

Индексация в Яндексе

У Яндекса тоже 2 типа роботов: основной и быстрый (Orange). Основной робот занимается индексацией всего интернета, а быстрый отвечает за поиск самых свежих документов, чтобы информация была доступна как можно быстрее (от нескольких минут до пары секунд).

Обновление индекса происходит раз в несколько дней ночью, когда нагрузки на серверы меньше. Процесс индексирования сайта обычно занимает от недели до месяца, а некачественные страницы удаляются из индекса.

Как проверить индексацию?

Уточним сразу пару моментов. Индексацию нужно проверять как в Google, так и в Яндексе. Более того, вы должны знать изначальное количество страниц на сайте. Это можно сделать с помощью краулеров типа Xenu, Screaming Frog, Netpeak Spider и других.

Как проверить индексацию:

Индексация сайта в поиске

Теперь, когда мы рассказали, что такое индексация, почему она так важна и как её проверить, приступим к практике.

Как ускорить индексацию?

Мы писали выше, что управлять индексацией, что бы кто не говорил, вы не можете. Но повлиять на процесс или даже ускорить возможно.

Советы по ускорению индексации

Как запретить индексацию?

Выше мы рассмотрели основные способы, как ускорить индексацию, и рассказали, что такое краулинговый бюджет и почему он ограничен для каждого сайта. Поэтому чтобы его не тратить зря, советуем закрывать от индексации служебные и технические страницы, кабинеты пользователей и конфиденциальную информацию, а также страницы в разработке и дубли.

3 основных способа запретить индексацию:

Индексация многостраничных сайтов

Отдельным столпом стоит работа с краулинговым бюджетом для многостраничных сайтов: маркетплейсы, агрегаторы, интернет-магазины, новостники, форумы и другие. Скажем по секрету, что владельцам небольших сайтов (до 1000 страниц) о бюджете краулинга можно волноваться меньше. А вот владельцам многостраничников придётся нелегко.

Как улучшить индексацию многостраничного сайта:

Эта статья уже проиндексирована

Надеемся, что материал получился максимально полезным и интересным, а мы ответили на все вопросы, касающиеся индексации. Тема сложная, и сразу во всём не разобраться, но уверяем, что, если последуете нашим советам, вы только улучшите свой сайт и его качество.

Если всё-таки вопросы остались, задавайте их нам!

Индексация сайта в 2021: Все что важно знать

Как поисковые системы индексируют сайты в 2021?

Как изменяются подходы к оптимизации индекса сайта?

Разберем важные нюансы об индексации сайтов поисковой системой, про которые мало кто знает.

Влияние индексации сайта на позиции в поисковой выдаче

Оптимизация индекса является отправной точкой в начале работ по продвижению любого сайта.

Удалить большое количество страниц из индекса крайне сложно.

Запрет в файле robots.txt решит проблему только для Яндекс. Для Google потребуется дополнительный переобход страниц, которые следует исключить из поисковой системы.

Нет инструментов по массовому удалению страниц из индекса Google. Официальный инструмент лишь скрывают страницы из поисковой выдачи.

Как индекс влияет на ранжирование? Влияние происходит так:

Как происходит индексация сайтов?

Сначала разберемся с термином. Что такое индексация сайта? Индексация сайта — сканирование, сохранение страниц в базу поисковой системы и дальнейшая обработка алгоритмами.

Процесс индексации сайта в упрощенном виде:

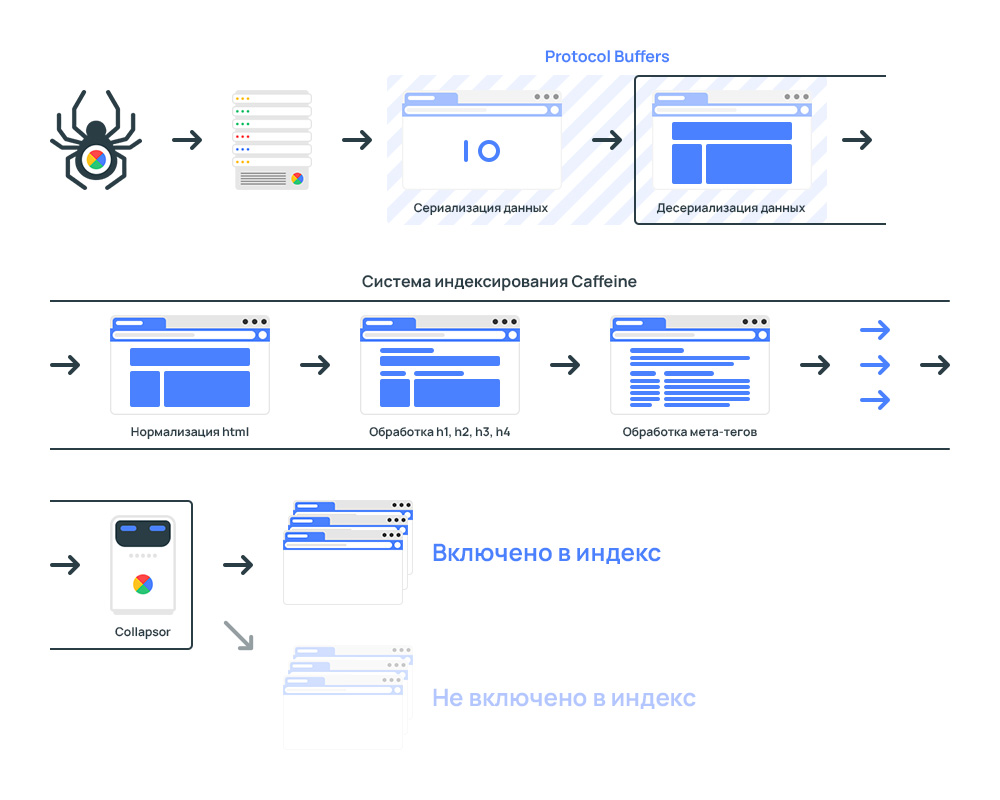

На практике схема индексации намного сложнее. Разберем как проходит процесс индексации на примере Google.

В процессе индексации участвует три отдельных системы: планировщик, робот для сканирования сайтов и система обработки.

Google Scheduler создает план на индексацию с учетом краулингового бюджета на сайт.

Googlebot сканирует сайты и сохраняет данные в бинарном виде.

Google Caffeine — система обработки проиндексированных страниц. Задача системы заключается в приеме, обработке и распределении страниц сайтов по индексам.

Каждую секунду Caffeine обрабатывает сотни тысяч страниц параллельно. Процесс индексации происходит постоянно. Индекс обновляется частями.

Что происходит внутри Caffeine?

Как работает Google Caffeine

Весь процесс системы индексирования:

Сначала происходит выгрузка данных, которые собрал поисковый краулер Googlebot.

Для скорости обработки данные передаются в бинарном виде, то бишь применяется процесс перевода структуры данных в последовательность байтов.

Для обработки данных применяется Protocol Buffers.

Protocol Buffers — протокол сериализации (передачи) структурированных данных, предложенный Google как эффективная бинарная альтернатива текстовому формату XML

После получение данных система индексации конвертирует данные в специальный формат, который способны анализировать роботы.

Страница передается в лексер. Предназначение лексера в поиске и исправлении ошибок в коде страницы.

Часто на сайтах встречаются ошибки в коде. Провести анализ контента со страниц с ошибками нет возможности технически.

С целью устранения ошибок код анализируются через HTML-лексер и автоматически исправляются.

Ошибки в верстке страницы напрямую никак не влияют на ранжирование.

Далее происходит нормализация данных. Страницы разбиваются на фрагменты. Например:

Google Collapsor в системе индексации сайтов

Collapsor является подсистемой в системе индексации.

Collapsor определяет куда переместить страницу. Варианты:

Именно Коллапсер присваивает страницам статус soft 404.

Коллапсер фильтрует индекс от бесполезных страниц: товар отсутствует, дубли, технические страницы и прочее.

Как обнаруживаются страницы дубли? Через анализ контрольной суммы checksum для каждой страницы, который основан на словах на странице. В результате, если есть две страницы с одинаковой контрольной суммой, то анализатор расценивает как дубли.

Индексация сайта гарантирует только обработку страниц. Попадание страниц в поисковую выдачу зависит от оценки страниц Google Коллапсером.

На основе Serving Index формируются результаты поисковой выдачи.

Google Serving Index — Индекс обслуживания

Индекс обслуживания или Serving Index — основной индекс поисковой системы состоящий из страниц, которые участвуют в ранжировании.

Находится в отдельных дата-центрах, откуда пользователи получают результаты поиска.

Документ попадает в Serving Index если:

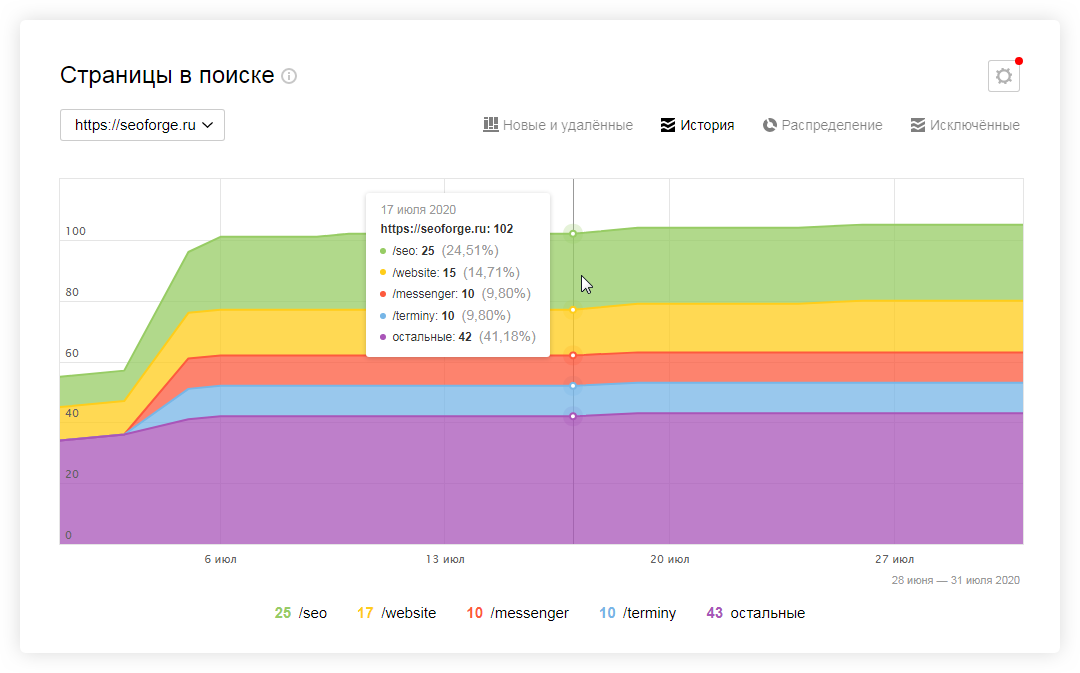

Проверка индексации сайта в Яндекс с учетом всех поддоменов сайта:

Проверка индексации в Яндекс по разделу:

Проверка индексации сайта в системе Google с учетом всех поддоменов сайта:

Проверка индексации по разделу:

С учетом вхождений в заголовки:

Проверка индексации по разделу:

Если страницы перестали открываться, то такие страницы подлежат удалению из индекса.

Если сайт отдает код ошибки, то страницы удаляются из индекса.

Уязвимость могут эксплуатировать конкуренты по выдаче.

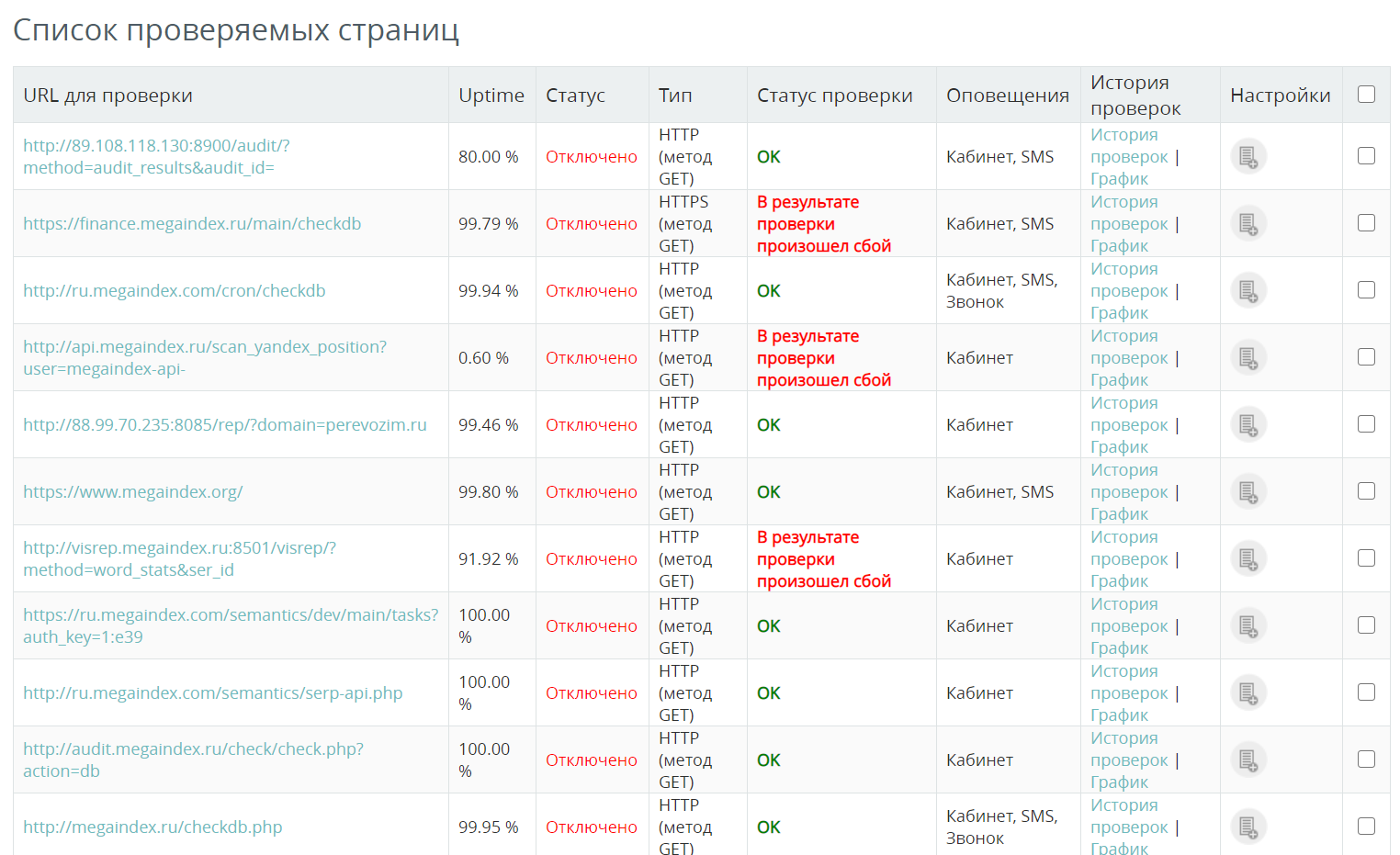

Как проверить доступность сайта? К примеру, можно использовать сервис от MegaIndex. Стоимость 1 проверки составляет 0.01 рублей. Если сервер сайта перестанет работать, система уведомит об инциденте удобным способом.

Вопросы и ответы

От чего зависит количество страниц подлежащих индексации?

Максимальное количество страниц, подлежащих индексации при очередном обходе сайта роботом определяет метрика под названием краулинговый бюджет.

Значение рассчитывает планировщик сканирования.

Как изменяются в подходы по оптимизации индекса?

Подходы к оптимизации индекса сайта действительно изменяются. К примеру, если раньше наличие большого объема страниц в поисковой выдаче сказывалось положительно на продвижении, то теперь ситуация обстоит иначе.

Большое количество страниц в индексе позволяло создавать на сайте значимый ссылочный статический вес. Сигнал передавался через ссылки на важные внутренние страницы. В результате ранжирование важных страниц улучшалось.

Но алгоритмы поисковых систем были улучшены. Тактика перестала быть эффективной. Большое количество страниц на сайте имеет смысл только в случае, если страницы способны приносить трафик.

Выводы

Задача по улучшению индексация сайта требует внимания, поскольку влияет на позиции сайта в поисковой выдаче.

Через сигналы Web Vitals на ранжирование могут влиять даже страницы, которые закрыты в robots.txt.

Открытыми к индексации должны быть такие страницы:

Приведенная информация является достоверной и подтвержденной из официальных источников.

В других поисковых системах процесс индексации схожий.

Если интересно узнать как найти на сайте бесполезные страницы и удалить страницы из индекса поисковой системы, напишите в комментариях.

Если остались вопросы по теме, напишите в комментариях.