как запретить индексацию поддомена в robots txt

Практические решения закрытия сайта или его части от индексации

Зачем закрывают сайт или какие-то его части от индексации поисковых систем? Ответов несколько

Вся статья будет неким хелпом по закрытию от индексации для различных ситуаций:

Решение: запрет на индексацию сайта с помощью robots.txt

Создаем текстовый файл с названием robots, получаем robots.txt.

Копируем туда этот код

Полученный файл с помощью FTP заливаем в корень сайта.

Если нужно закрыть индексацию сайта только от Яндекс:

Если же скрываем сайт только от Google, то код такой:

Способ первый

Каждая строчка для отдельной поисковой системы

Способ второй и третий

Способ четвертый

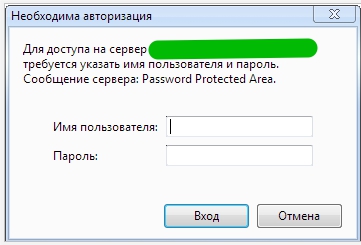

Запретить индексацию с помощью доступа к сайту только по паролю

Авторизацию уже увидите, но она пока еще не работает

Теперь необходимо добавить пользователя в файл паролей:

USERNAME это имя пользователя для авторизации. Укажите свой вариант.

Задача: закрыть от индексации поддомен

Поддомен для поисковых систем является отдельным сайтом, из чего следует, что для него подходят все варианты того, как закрыть от индексации сайт.

Закрываем блок на сайте от индекса

Довольно часто требуется закрыть от индексации определенный блок: меню, счетчик, текст или какой-нибудь код.

Когда был популярен в основном Яндекс, а Google все само как то в топ выходило, все использовали вариант Тег «noindex»

Как это реализовать?

BASE64.js. Здесь я его приводить не буду, в данном контексте он нам не так интересен.

Переменные seoContent и seoHrefs. В одну записываем html код, в другую ссылки.

В robots.txt обязательно скрываем от индексации файл SEOhide.js.

Универсальный вариант скрытия картинок от индексации

К примеру, вы используете на сайте картинки, но они не являются оригинальными. Есть страх, что поисковые системы воспримут их негативно.

Код элемента, в данном случае ссылки, на странице, будет такой:

Скрипт, который будет обрабатывать элемент:

Задача: закрыть внешние или внутренние ссылки от индексации

Обычно это делают для того, чтобы не передавать вес другим сайтам или при перелинковке уменьшить уходящий вес текущей страницы.

Создаем файл transfers.js

Эту часть кода вставляем в transfers.js

Этот файл, размещаем в соответствующей папке (как в примере «js») и на странице в head вставляем код:

А это и есть сама ссылка, которую нужно скрыть от индексации:

Как закрыть от индексации страницу на сайте

это серый метод, использовать в крайних мерах

Как закрыть от индексации сразу весь раздел на проекте

1 Вариант реализовать это с помощь robots.txt

Конечно же проще всего это прописать запрет в robots, но наша практика показывает, что это не 100% вариант и поисковые системы бывает игнорируют запреты.

Закрываем папку от индексации

Единственный вариант для отдельной папки это реализация через robots.txt

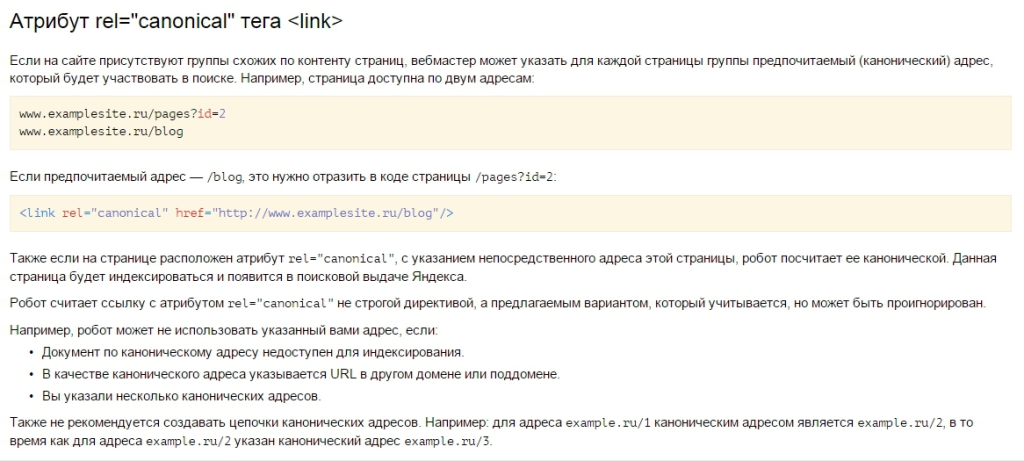

Пять вариантов закрыть дубли на сайте от индексации Яндекс и Google

Ну странице дубля к коде необходимо указать

Если что то упустили, будем рады любым дополнениям в комментариях.

Верные способы закрыть сайт от поисковиков

Чтобы оптимизировать информационный ресурс, можно временно скрыть его от поисковиков. Посторонним пользователям не нужно видеть повторяющуюся или неуникальную информацию, технические данные или дубли страниц.

В этой статье расскажем о пяти основных способов закрытия сайта от индексации.

1. Настройка доступа с использованием WordPress

Метод подойдет вебмастерам, создавшим интернет-портал на базе WordPress. Чтобы закрыть сайт от поисковых систем полностью, откройте панель управления. Далее следуйте по цепочке: Настройки > Чтение > Видимость для поисковиков > Попросить поисковые системы не индексировать сайт > Сохранить изменения.

После этого поисковики сами будут решать, показывать информационный ресурс пользователям или нет. Google может оставить материалы в результатах выдачи по запросам, не обращая внимания на рекомендацию владельца сайта, а Яндекс, как правило, останавливает индексацию данных.

2. Работа с файлом robots.txt

Скрыть весь информационный портал или его часть можно, создав пустой документ в формате txt и дав ему название robots. Файл надо поместить в корневую папку сайта. Читать подробнее о robots.txt.

Чтобы закрыть сайт от всех поисковых систем, в документе надо прописать следующее:

Проверить изменения можно, набрав в адресной строке название домена.ru/robots.txt. Если браузер покажет ошибку 404, то документ находится не корневой папке ресурса.

Запрет на индексацию отдельной папки или файла

Скрыть отдельную папку поможет следующая команда:

User-agent: *

Disallow: /folder/

Закрыть определенный файл можно, указав в команде путь к нему:

User-agent: *

Disallow: /folder/file.php

Остановка индексирования сайта в Яндексе

Остановить индексирование интернет-ресурса в Яндексе можно, сохранив в открытом файле текст:

User-agent: Yandex

Disallow: /

Закрытие сайта от Google

Скрыть информацию только для Google можно, сохранив в robots.txt следующее:

User-agent: Googlebot

Disallow: /

Обращение к другим поисковым системам

Для запрета индексации веб-сайта другими поисковиками, в редактируемом файле в строке user-agent после двоеточия надо указывать имена их поисковых роботов:

Запрет на индексирование картинок

Код для остановки показа картинок зависит от их формата:

User-agent: *

Disallow: *.png

Disallow: *.jpg

Disallow: *.gif

Закрытие поддомена

Заблокировать поддомен, можно, открыв robots.txt в корневой папке поддомена и указав в robots.txt следующее:

Если нужного файла нет, его следует создать самостоятельно.

3. Добавление мета-тега name=»robots»

Мета-тег robots обязателен для соблюдения всеми поисковиками. Чтобы скрыть веб-сайт от индексации, между тегамиинадо вставить кодили.

4. Изменение настроек сервера

Можно попытаться решить проблему через сервер. Если вы не уверены в своих знаниях, лучше обратиться к системному администратору. Действия непрофессионалов могут привести к поломке сайта.

Перед изменением настроек сервера лучше сделать бэкап сайта. Он представляет собой сохранение в отдельном месте всех файлов, баз данных, почты, FTP-аккаунтов и других параметров хостинга. Это позволит вернуть старую версию интернет-ресурса в случае ошибки.

SetEnvIfNoCase User-Agent «^Googlebot» search_bot

SetEnvIfNoCase User-Agent «^Yandex» search_bot

SetEnvIfNoCase User-Agent «^Yahoo» search_bot

SetEnvIfNoCase User-Agent «^Aport» search_bot

SetEnvIfNoCase User-Agent «^msnbot» search_bot

SetEnvIfNoCase User-Agent «^spider» search_bot

SetEnvIfNoCase User-Agent «^Robot» search_bot

SetEnvIfNoCase User-Agent «^php» search_bot

SetEnvIfNoCase User-Agent «^Mail» search_bot

SetEnvIfNoCase User-Agent «^bot» search_bot

SetEnvIfNoCase User-Agent «^igdeSpyder» search_bot

SetEnvIfNoCase User-Agent «^Snapbot» search_bot

SetEnvIfNoCase User-Agent «^WordPress» search_bot

SetEnvIfNoCase User-Agent «^BlogPulseLive» search_bot

SetEnvIfNoCase User-Agent «^Parser» search_bot

5. Использование HTTP заголовка X-Robots-Tag

Директивы для тега X-Robots:

Перед использованием директив надо проверить, распознает ли их нужная поисковая система. Значения, которые распознает Google, более подробно описаны в Search Console.

Яндекс поддерживает директивы, описанные в службе поддержки вебмастера.

Метод дает возможность управлять статичными файлами — теми, которые не нужно обрабатывать серверу (JS, CSS, jpg, png, html, txt и т. д.).

Header set X-Robots-Tag “noindex, nofollow”

Настройка файла с применением PHP

Способ рассчитан на работу с динамическими страницами интернет-ресурса, обрабатываемыми сервером (php, pl, cgi и т. д.), с помощью языка программирования PHP. Он применяется реже, чем X-Robots-Tag.

Для изменения настроек откройте документ index.php, находящийся в корне сайта (папка public_html). В нем между тегамиивставьте строку header «X-Robots — Tag: выбранная директива».

Выводы

Изменение настроек ресурса в WordPress не гарантирует того, что контент не будут показывать в выдаче поисковиков. Команды в файле robots.txt тоже носят рекомендательный характер для роботов. Скрыть веб-сайт можно, добавив тег name=»robots» в HTML-код портала.

Изменять настройки сервера и применять заголовок X-Robots-Tag можно, только если вы уверены в своих знаниях. В противном случае лучше обратиться к профессионалам.

Запрет индексации в robots.txt

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

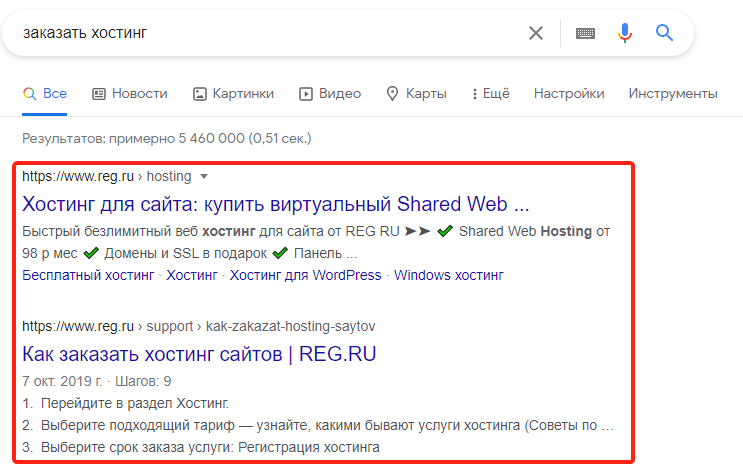

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.txt и загрузить его на хостинг. Или воспользоваться плагином Yoast SEO, если сайт создан на движке WordPress.

Чтобы запретить индексацию всего сайта:

Добавьте в начало нужные строки.

Как закрыть сайт от индексации?

Многие вебмастера при работе с сайтом могут вносить правки, которые сильно сказываются на его дизайне и функционале. В некоторых случаях это может быть связано с разработкой нового оформления для проекта, добавлении различных фишек и т.п. В результате возникает ситуация, когда требуется закрыть сайт от индексации в поисковых системах, чтобы поисковые боты не видели веб-сайт на стадии разработки.

На помощь в данном случае придет файл robots.txt, который должен лежать в корневой папке проекта. Чтобы закрыть сайт от индексации во всех поисковых системами потребуется разместить в файл robots.txt следующие строки:

Иногда вы можете запретить индексировать сайт отдельным поисковым роботам (у каждого поисковика имеется свой), для этого потребуется вместо звездочки в robots.txt прописать обращение к поисковому роботу.

Запретить индексацию папки или директории сайта

С помощью роботса также можно закрывать отдельные разделы сайта. Для этого следует добавить вот такие значения:

Где name – название папки. Это запретит индексацию всех адресов сайта, которые расположены внутри раздела name.

При этом можно дополнительно прописать инструкцию, которая позволит открыть для индексации отдельный файл. Для этого прописываем следующие строки:

В результате роботы поисковых систем не будут сканировать все содержимое папки name, кроме раздела page_1.

Данную инструкцию также можно отдельно прописывать для поисковых ботов.

Запретить индексацию изображений

С помощью роботса можно без проблем закрыть индексацию изображений на сайте. Для этого разместите в файле строку Dissallow: с указанием формата изображений, который не должен быть проиндексирован поисковыми ботами. Например:

Закрыть от индексации поддомены

Поисковые системы распознают все поддомены как отдельные сайты. Поэтому необходимо на каждом из них размещать свой роботс. Находится он в корневой папке вашего поддомена. Чтобы закрыть от индексации нужный вам поддомен, добавьте файл robots.txt инструкцию, которая была указана выше.

Список дополнительных директив, которые используются в файле robots.txt

Помимо стандартных директив, Google, Яндекс и прочие поисковики знают еще несколько.

Инструкции для других поисковых систем

С помощью строки User-agent: вы можете обратиться в robots.txt к разным известных поисковых систем. Каждая из них имеет своего робота, который проводит сканирование страниц сайта. Помимо стандартных обращений к Яндексу и Google, которые были описаны выше, можно прописать обращения и к другим поисковым ботам.

Закрыть страницу от индексации

Помимо файла robots.txt можно запретить к индексации ту или иную страницу проекта. Для этого используется мета-тег robots, который должен быть прописан в html-коде сайта. Поисковики воспринимают его, и он имеет довольно высокий приоритет. Для того чтобы запретить индексирование URL, добавьте в код следующие строки:

Также можно использовать альтернативный вариант:

Мета тег дает возможность обращаться к поисковым ботам. Для этого нужно заменить в нем строчку robots на yandex или googlebot.

Руководство: как закрыть сайт от индексации в поисковых системах? Работа с файлом robots.txt

На стадии разработки и/или редизайна проекта бывают ситуации, когда лучше не допускать поисковых роботов на сайт или его копию. В этом случае рекомендуется закрыть сайт от индексации поисковых систем. Сделать это можно следующим образом:

Закрыть сайт от индексации очень просто, достаточно создать в корне сайта текстовый файл robots.txt и прописать в нём следующие строки:

User-agent: Yandex

Disallow: /

Такие строки закроют сайт от поискового робота Яндекса.

А таким образом можно закрыть сайт от всех поисковых систем (Яндекса, Google и других).

Как закрыть от индексации отдельную папку? #

Отдельную папку можно закрыть от поисковых систем в том же файле robots.txt с её явным указанием (будут скрыты все файлы внутри этой папки).

User-agent: *

Disallow: /folder/

Если какой-то отдельный файл в закрытой папке хочется отдельно разрешить к индексации, то используйте два правила Allow и Disallow совместно:

User-agent: *

Аllow: /folder/file.php

Disallow: /folder/

Как закрыть отдельный файл в Яндексе? #

User-agent: Yandex

Disallow: /folder/file.php

Как проверить, в индексе документ или нет? #

Проще всего осуществить проверку в рамках сервиса «Пиксель Тулс», бесплатный инструмент «Определение возраста документа в Яндексе» позволяет ввести URL списком. Если документ отсутствует в индексе, то в таблице будет выведено соответствующее значение.

Анализ проведён с помощью инструментов в сервисе Пиксель Тулс.

Как скрыть от индексации картинки? #

Картинки форматов jpg, png и gif могут быть запрещены к индексации следующими строчками в robots.txt:

User-Agent: *

Disallow: *.jpg

Disallow: *.png

Disallow: *.gif

Как закрыть поддомен? #

У каждого поддомена на сайте, в общем случае, имеется свой файл robots.txt. Обычно он располагается в папке, которая является корневой для поддомена. Требуется скорректировать содержимое файла с указанием закрываемых разделов с использованием директории Disallow. Если файл отсутствует — его требуется создать.

При использовании CDN-версии #

Как обращаться к другим поисковым роботам (список) #

У каждой поисковой системы есть свой список поисковых роботов (их несколько), к которым можно обращаться по имени в файле robots.txt. Приведем список основных из них (полные списки ищите в помощи Вебмастерам):

Прочие директивы в robots.txt #

Поисковая система Яндекс также поддерживает следующие дополнительные директивы в файле:

«Crawl-delay:» — задает минимальный период времени в секундах для последовательного скачивания двух файлов с сервера. Также поддерживается и большинством других поисковых систем. Пример записи: Crawl-delay: 0.5

«Clean-param:» — указывает GET-параметры, которые не влияют на отображение контента сайта (скажем UTM-метки или ref-ссылки). Пример записи: Clean-param: utm /catalog/books.php

«Sitemap:» — указывает путь к XML-карте сайта, при этом, карт может быть несколько. Также директива поддерживается большинством поисковых систем (в том числе Google). Пример записи: Sitemap: https://pixelplus.ru/sitemap.xml

Закрыть страницу и сайт с помощью meta-тега name=»robots» #

Также, можно закрыть сайт или заданную страницу от индексации с помощь мета-тега robots. Данный способ является даже предпочтительным и с большим приоритетом выполняется пауками поисковых систем. Для скрытия от индексации внутри зоны документа устанавливается следующий код:

Или (полная альтернатива):

С помощью meta-тега можно обращаться и к одному из роботов, используя вместо name=»robots» имя робота, а именно:

Для паука Google:

Или для Яндекса: