Энтропия что это значит

Энтропия — что это такое: объяснение термина простыми словами

Энтропия: определение и история появления термина

История появления термина

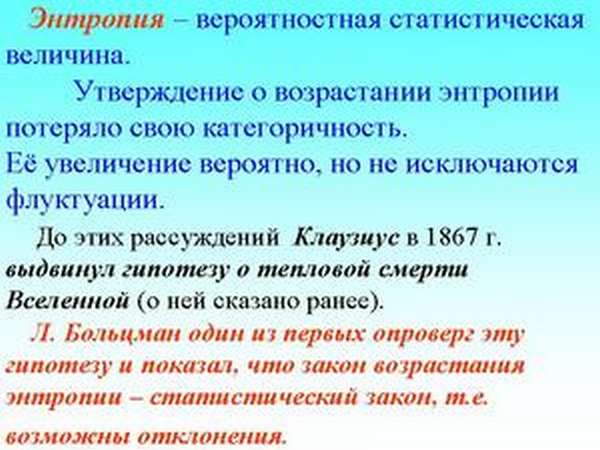

Энтропия как определение состояния системы была введена в 1865 году немецким физиком Рудольфом Клаузиусом, чтобы описать способность теплоты превращаться в другие формы энергии, главным образом в механическую. С помощью этого понятия в термодинамике описывают состояние термодинамических систем. Приращение этой величины связано с поступлением тепла в систему и с температурой, при которой это поступление происходит.

Определение термина из Википедии

Этот термин долгое время использовался только в механической теории тепла (термодинамике), для которой оно вводилось. Но со временем это определение перешло в другие области и теории. Существует несколько определений термина «энтропия».

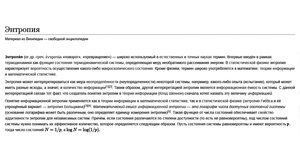

Википедия даёт краткое определение для нескольких областей, в которых этот термин используется:«Энтропия (от др.-греч. ἐντροπία «поворот»,«превращение») — часто употребляемый в естественных и точных науках термин. В статистической физике характеризует вероятность осуществления какого-либо макроскопического состояния. Помимо физики, этот термин широко используется в математике: теории информации и математической статистике».

Виды энтропий

Этот термин используется в термодинамике, экономике, теории информации и даже в социологии. Что же он определяет в этих областях?

В физической химии (термодинамике)

Энтропия — это мера беспорядка. Как определить беспорядок? Один из способов — приписать каждому состоянию число вариантов, которыми это состояние можно реализовать. И чем больше таких способов реализации, тем больше значение энтропии. Чем больше организованно вещество (его структура), тем ниже его неопределённость (хаотичность).

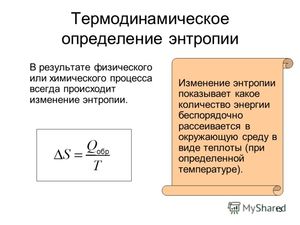

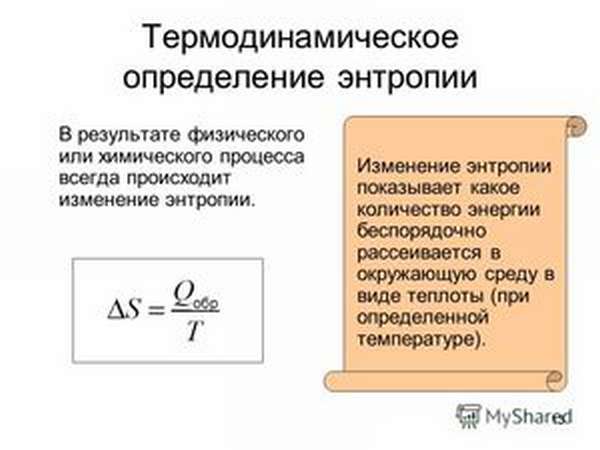

Абсолютное значение энтропии (S абс.) равно изменению имеющейся у вещества или системы энергии во время теплопередачи при данной температуре. Его математическая величина определяется из значения теплопередачи (Q), разделённого на абсолютную температуру (T), при которой происходит процесс: S абс. = Q / T. Это означает, что при передаче большого количества теплоты показатель S абс. увеличится. Тот же эффект будет наблюдаться при теплопередаче в условиях низких температур.

В экономике

В статистической физике или теории информации

Информационная энтропия (неопределённость)— это мера непредсказуемости или неопределённости некоторой системы. Эта величина помогает определить степень беспорядочности проводимого эксперимента или события. Чем больше количество состояний, в которых может находиться система, тем больше значение неопределённости. Все процессы упорядочивания системы приводят к появлению информации и снижению информационной неопределённости.

С помощью информационной непредсказуемости можно выявить такую пропускную способность канала, которая обеспечит надёжную передачу информации (в системе закодированных символов). А также можно частично предсказывать ход опыта или события, деля их на составные части и высчитывая значение неопределённости для каждой из них. Такой метод статистической физики помогает выявить вероятность события. С его помощью можно расшифровать закодированный текст, анализируя вероятность появления символов и их показатель энтропии.

Существует такое понятие, как абсолютная энтропия языка. Эта величина выражает максимальное количество информации, которое можно передать в единице этого языка. За единицу в этом случае принимают символ алфавита языка (бит).

В социологии

Энтропия: тезисно и на примерах

Пример 1. Программа Т9. Если в слове будет небольшое количество опечаток, то программа легко распознает слово и предложит его замену. Чем больше опечаток, тем меньше информации о вводимом слове будет у программы. Следовательно, увеличение беспорядка приведёт к увеличению информационной неопределённости и наоборот, чем больше информации, тем меньше неопределённость.

Пример 2. Игральные кости. Выкинуть комбинацию 12 или 2 можно только одним способом: 1 плюс 1 или 6 плюс 6. А максимальным числом способов реализуется число 7 (имеет 6 возможных комбинаций). Непредсказуемость реализации числа семь самая большая в этом случае.

Пример. Н2О (всем известная вода) в своём жидком агрегатном состоянии будет обладать большей энтропией, чем в твёрдом (лёд). Потому что в кристаллическом твёрдом теле каждый атом занимает определённое положение в кристаллической решётке (порядок), а в жидком состоянии у атомов определённых закреплённых положений нет (беспорядок). То есть тело с более жёсткой упорядоченностью атомов имеет более низкое значение энтропии (S). Белый алмаз без примесей обладает самым низким значением S по сравнению с другими кристаллами.

Пример 2. Чем выше порядок на рабочем столе, тем больше информации можно узнать о вещах, которые на нём находятся. В этом случае упорядоченность предметов снижает энтропию системы «рабочий стол».

Пример 3. Информация о классе больше на уроке, чем на перемене. Энтропия на уроке ниже, так как ученики сидят упорядочено (больше информации о местоположении каждого ученика). А на перемене расположение учеников меняется хаотично, что повышает их энтропию.

Пример. При реакции щелочного металла с водой выделяется водород. Водород-это газ. Так как молекулы газа движутся хаотично и имеют высокую энтропию, то рассматриваемая реакция происходит с увеличением её значения. То есть энтропия химической системы станет выше.

В заключение

Если объединить всё вышесказанное, то получится, что энтропия является мерой беспорядка или неопределённости системы и её частей. Интересен тот факт, что всё в природе стремится к максимуму энтропии, а человек — к максимуму информации. И все рассмотренные выше теории направлены на установление баланса между стремлением человека и естественными природными процессами.

Энтропия что это такое: объяснение термина простыми словами

Энтропия: определение и история появления термина

История появления термина

Энтропия как определение состояния системы была введена в 1865 году немецким физиком Рудольфом Клаузиусом, чтобы описать способность теплоты превращаться в другие формы энергии, главным образом в механическую. С помощью этого понятия в термодинамике описывают состояние термодинамических систем. Приращение этой величины связано с поступлением тепла в систему и с температурой, при которой это поступление происходит.

Определение термина из Википедии

Этот термин долгое время использовался только в механической теории тепла (термодинамике), для которой оно вводилось. Но со временем это определение перешло в другие области и теории. Существует несколько определений термина «энтропия».

Википедия даёт краткое определение для нескольких областей, в которых этот термин используется:«Энтропия (от др.-греч. ἐντροπία «поворот»,«превращение») — часто употребляемый в естественных и точных науках термин. В статистической физике характеризует вероятность осуществления какого-либо макроскопического состояния. Помимо физики, этот термин широко используется в математике: теории информации и математической статистике».

Виды энтропий

Этот термин используется в термодинамике, экономике, теории информации и даже в социологии. Что же он определяет в этих областях?

В физической химии (термодинамике)

Энтропия — это мера беспорядка. Как определить беспорядок? Один из способов — приписать каждому состоянию число вариантов, которыми это состояние можно реализовать. И чем больше таких способов реализации, тем больше значение энтропии. Чем больше организованно вещество (его структура), тем ниже его неопределённость (хаотичность).

Абсолютное значение энтропии (S абс.) равно изменению имеющейся у вещества или системы энергии во время теплопередачи при данной температуре. Его математическая величина определяется из значения теплопередачи (Q), разделённого на абсолютную температуру (T), при которой происходит процесс: S абс. = Q / T. Это означает, что при передаче большого количества теплоты показатель S абс. увеличится. Тот же эффект будет наблюдаться при теплопередаче в условиях низких температур.

В экономике

В статистической физике или теории информации

Информационная энтропия (неопределённость)— это мера непредсказуемости или неопределённости некоторой системы. Эта величина помогает определить степень беспорядочности проводимого эксперимента или события. Чем больше количество состояний, в которых может находиться система, тем больше значение неопределённости. Все процессы упорядочивания системы приводят к появлению информации и снижению информационной неопределённости.

С помощью информационной непредсказуемости можно выявить такую пропускную способность канала, которая обеспечит надёжную передачу информации (в системе закодированных символов). А также можно частично предсказывать ход опыта или события, деля их на составные части и высчитывая значение неопределённости для каждой из них. Такой метод статистической физики помогает выявить вероятность события. С его помощью можно расшифровать закодированный текст, анализируя вероятность появления символов и их показатель энтропии.

Существует такое понятие, как абсолютная энтропия языка. Эта величина выражает максимальное количество информации, которое можно передать в единице этого языка. За единицу в этом случае принимают символ алфавита языка (бит).

В социологии

Энтропия: тезисно и на примерах

Пример 1. Программа Т9. Если в слове будет небольшое количество опечаток, то программа легко распознает слово и предложит его замену. Чем больше опечаток, тем меньше информации о вводимом слове будет у программы. Следовательно, увеличение беспорядка приведёт к увеличению информационной неопределённости и наоборот, чем больше информации, тем меньше неопределённость.

Пример 2. Игральные кости. Выкинуть комбинацию 12 или 2 можно только одним способом: 1 плюс 1 или 6 плюс 6. А максимальным числом способов реализуется число 7 (имеет 6 возможных комбинаций). Непредсказуемость реализации числа семь самая большая в этом случае.

Пример. Н2О (всем известная вода) в своём жидком агрегатном состоянии будет обладать большей энтропией, чем в твёрдом (лёд). Потому что в кристаллическом твёрдом теле каждый атом занимает определённое положение в кристаллической решётке (порядок), а в жидком состоянии у атомов определённых закреплённых положений нет (беспорядок). То есть тело с более жёсткой упорядоченностью атомов имеет более низкое значение энтропии (S). Белый алмаз без примесей обладает самым низким значением S по сравнению с другими кристаллами.

Пример 2. Чем выше порядок на рабочем столе, тем больше информации можно узнать о вещах, которые на нём находятся. В этом случае упорядоченность предметов снижает энтропию системы «рабочий стол».

Пример 3. Информация о классе больше на уроке, чем на перемене. Энтропия на уроке ниже, так как ученики сидят упорядочено (больше информации о местоположении каждого ученика). А на перемене расположение учеников меняется хаотично, что повышает их энтропию.

Пример. При реакции щелочного металла с водой выделяется водород. Водород-это газ. Так как молекулы газа движутся хаотично и имеют высокую энтропию, то рассматриваемая реакция происходит с увеличением её значения. То есть энтропия химической системы станет выше.

В заключение

Если объединить всё вышесказанное, то получится, что энтропия является мерой беспорядка или неопределённости системы и её частей. Интересен тот факт, что всё в природе стремится к максимуму энтропии, а человек — к максимуму информации. И все рассмотренные выше теории направлены на установление баланса между стремлением человека и естественными природными процессами.

Все меняется, и некоторым из нас это не всегда нравится. Но согласно одной из точек зрения, энтропия Вселенной и природы в целом (то есть степень беспорядка или случайности в системе) может быть тем, что в первую очередь способствовало возникновению жизни.

реклама

Согласно этой точке зрения, когда группа атомов приводится в движение внешним источником энергии, например Солнцем, и окружена источником тепла, например атмосферой, она постепенно перестраивается таким образом, чтобы рассеивать все больше энергии. С этого момента, при определенных условиях, материя неумолимо приобретает свойства, ассоциирующиеся с жизнью.

Однако энтропию также связывают с тепловой смертью Вселенной. Вот все, что необходимо знать об энтропии в термодинамике и о том, как она влияет на Вселенную и, в конечном счете, на нас.

Что такое энтропия Вселенной?

Хотя в физике это не одно и то же, полезно вспомнить о теории хаоса и о том, как она связана с энтропией, и, в конечном счете, какое влияние энтропия может оказывать на Вселенную.

реклама

Согласно теории хаоса, в кажущейся случайности хаотических, сложных систем есть скрытые закономерности и взаимосвязи. Если знать начальные условия и выяснить эти базовые закономерности, то можно предсказать нарушения, которые произойдут в будущем. Другими словами, хаос не так беспорядочен и случаен, как может показаться.

В своей самой простой формулировке энтропия определяется как мера тепловой энергии в системе на единицу температуры, которая не может быть использована для совершения полезной работы. Поскольку работа получается в результате упорядоченного движения молекул, энтропия также является мерой молекулярного беспорядка, или случайности, в системе.

Не только физика, но и многие дисциплины нашли применение этой концепции, включая химию, биологию, изменение климата, социологию, экономику, теорию информации и даже бизнес.

Но давайте остановимся на физике, а точнее, на фундаментальных законах термодинамики.

Кто ввел понятие энтропии?

реклама

Несмотря на то, что понятие энтропии применяется в различных дисциплинах, оно берет свое начало в физике. Изучая сохранение механической энергии в своей работе » Основные принципы равновесия и движения» (1803), французский математик Лазар Карно предложил, что ускорения и удары движущихся частей в машине представляют собой «потери момента активности». Момент активности» Карно сопоставим с современным понятием работы в термодинамике. Таким образом, в любом естественном процессе существует неотъемлемая тенденция к рассеиванию полезной энергии.

Другие ученые исследовали эту «потерянную» энергию, и в последней половине 19 века они указали, что это не настоящее исчезновение, а преобразование. Это и есть концепция сохранения энергии, которая проложила путь к первому закону термодинамики. Такие ученые, как Джеймс Джоуль, Юлиус Майер, Герман Гельмгольц и Уильям Томпсон (также известный как лорд Кельвин), опубликовали работы, исследующие эту концепцию.

реклама

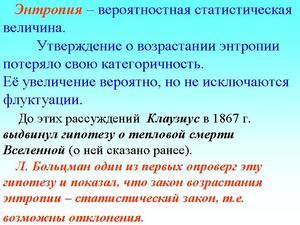

Но термин «энтропия» появился в работах немецкого физика Рудольфа Клаузиуса, который сегодня считается одним из авторов термодинамики.

В 1850-х годах он представил изложение Второго закона термодинамики применительно к тепловому насосу. Заявление Клаузиуса подчеркивало тот факт, что невозможно построить устройство, работающее по циклу и не производящее никакого другого эффекта, кроме передачи тепла от более холодного тела к более горячему.

В 1860-х годах он придумал слово «энтропия» от греческого слова, означающего превращение, или поворотный пункт, для обозначения необратимой потери тепла. Он описал ее как функцию состояния в термодинамическом цикле, в частности в цикле Карно, теоретическом цикле, предложенном сыном Лазаря Карно, Сади Карно.

В 1870-х годах австрийский физик и философ Людвиг Больцман переосмыслил и адаптировал определение энтропии к статистической механике. Ближе к тому, что подразумевает этот термин сейчас, он описывает энтропию как измерение всех возможных микро-состояний в системе, макроскопическое состояние которой было изучено. Как могут измениться все наблюдаемые свойства системы? Сколькими способами? Эти вопросы охватывают понятие беспорядка, которое лежит в основе одного из понятий энтропии.

Находится ли Вселенная в состоянии энтропии?

Еще в 19 веке Рудолф Клаузиус вывел, что энергия Вселенной постоянна, а ее энтропия имеет тенденцию к увеличению с течением времени.

По мнению космологов, затем эта точка «взорвалась», расширяясь и распространяясь со скоростью, превышающей скорость света, и породив все частицы, античастицы и излучения во Вселенной.

Конечно, для этого должно было произойти огромное количество процессов связанных с изменением энтропии. Однако если мы подумаем о непрерывном увеличении энтропии, которое происходило на протяжении всех этих лет, то сможем сделать вывод, что энтропия Вселенной сейчас должна быть намного больше. На самом деле, согласно расчетам, энтропия Вселенной сегодня примерно в квадриллион раз больше, чем во время Большого взрыва.

Почему энтропия Вселенной растет?

Черные дыры обладают огромной концентрацией массы, которая обеспечивает им исключительно сильное гравитационное поле. Поэтому они допускают множественность микросостояний. В связи с этим Стивен Хокинг предположил, что черные дыры выделяют тепловое излучение вблизи своих горизонтов событий. Это излучение Хокинга может привести к потере массы и окончательному испарению черных дыр.

Но помните, что черные дыры подчиняются второму закону термодинамики, который гласит, что энтропия всегда будет иметь тенденцию к увеличению. Поэтому они будут набирать все большую массу и сливаться с другими черными дырами, превращаясь в сверхмассивные чёрные дыры. А когда они в конце концов распадутся, излучение Хокинга, создаваемое распадающимися чёрными дырами, будет иметь такое же количество возможных состояний, как и сама ранее существовавшая черная дыра. Согласно этой точке зрения, ранняя Вселенная имела низкую энтропию из-за меньшего количества или гораздо меньших размеров черных дыр.

Существует ли предел энтропии во Вселенной?

Как бы мы ни говорили о тенденции к увеличению энтропии, законы термодинамики также подразумевают состояние максимальной энтропии.

В повседневной жизни мы можем наблюдать это, когда наш кофе остывает в чашке. Когда кофе достигает комнатной температуры, это означает, что он находится в тепловом равновесии с окружающей средой. В кипящей воде, используемой для приготовления кофе, было много возбужденных атомов, но они замедлились и в конце концов достигли максимальной энтропии для данной системы.

При постоянной, стабильной температуре во всем космосе больше не останется энергии для совершения работы, так как энтропия достигнет максимального уровня. Все эти предположения составляют теорию тепловой смерти Вселенной. Эта теория также известна под названием «Большой заморозки», поскольку в этом сценарии энтропия Вселенной будет постоянно возрастать, пока не достигнет максимального значения. В этот роковой момент все тепло в нашей Вселенной будет распределено абсолютно равномерно, не оставляя места для полезной энергии.

Может ли энтропия Вселенной уменьшиться?

Можно с уверенностью сказать, что энтропия во Вселенной в какой-то момент уменьшилась, потому что в ней существует определенный порядок. Гравитационные взаимодействия могут к примеру превращать туманности в звезды. Это своего рода порядок.

Энтропия может уменьшаться без нарушения второго закона термодинамики до тех пор, пока она увеличивается в других частях системы. В конце концов, второй закон термодинамики не говорит, что энтропия не может уменьшаться в определенных частях системы, а только то, что общая энтропия системы имеет естественную тенденцию к увеличению.

При этом общая энтропия Вселенной не уменьшается. Как было сказано выше, энтропия будет иметь тенденцию к увеличению, пока не достигнет своего максимального уровня и не приведет к тепловой смерти. Это стационарное состояние термодинамического равновесия, в котором энтропия не только максимальна, но и постоянна, и она будет оставаться такой, пока не произойдет приток энергии, который оживит систему.

Тогда цикл может повториться. С новой, дополнительной энергией, совершающей работу, останется часть энергии, не способной совершить работу, которая превратится в тепло. Это снова увеличит энтропию системы. Но откуда возьмется эта энергия? Что заставит оставшиеся лептоны и фотоны, если таковые имеются, взаимодействовать?